北理工團隊在點云目標智能識別領域取得系列突破性進展

發(fā)布日期:2025-04-23 供稿:光電學院 攝影:光電學院

編輯:盛筠 審核:李家方 閱讀次數(shù):

點云目標識別是實現(xiàn)三維環(huán)境智能感知與理解的重要技術之一,在自動駕駛、無人系統(tǒng)、空間探測等領域具有廣泛的應用前景。然而,在實際場景下,受傳感器噪聲、環(huán)境干擾等因素影響,點云數(shù)據(jù)常存在擾動、缺失與形變等退化現(xiàn)象,顯著降低了傳統(tǒng)識別方法的準確性與泛化能力。針對真實復雜環(huán)境下點云目標智能識別中的關鍵科學問題和難題,許廷發(fā)、李佳男科研團隊開展了原創(chuàng)方法和關鍵技術攻關,取得了突破性研究進展,相關論文陸續(xù)發(fā)表于IEEE TPAMI、NeurIPS (CCF-A)、ICCV (CCF-A)和ICLR等人工智能領域國際頂級期刊和會議,受到學術界的廣泛關注。

科研團隊主要從點云數(shù)據(jù)增強、特征學習與時序建模三個層面開展系統(tǒng)性研究,提出了樣本自適應在線數(shù)據(jù)擴增方法、感知對抗模式捕獲策略,以及時序關聯(lián)高效建模框架:

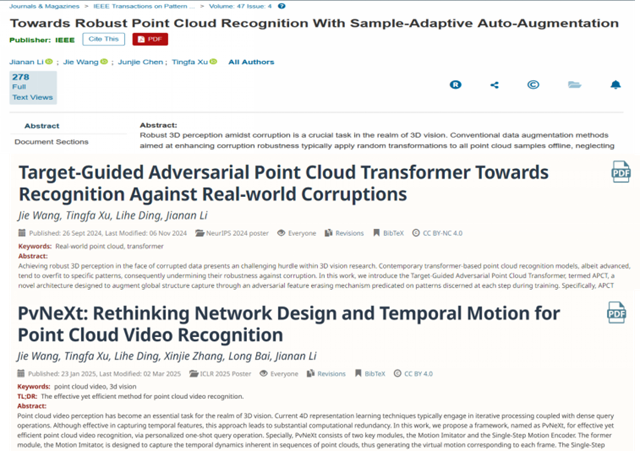

1.樣本自適應在線數(shù)據(jù)擴增方法(IEEE TPAMI 2025):該方法結(jié)合輸入點云的空間結(jié)構特征與感知模型狀態(tài),自適應對樣本施加多級形變與遮擋,生成貼近真實失真場景的點云數(shù)據(jù),拓展訓練樣本的多樣性,從而顯著提升模型魯棒性(圖1)。

圖1. 樣本自適應在線擴增方法示意圖。

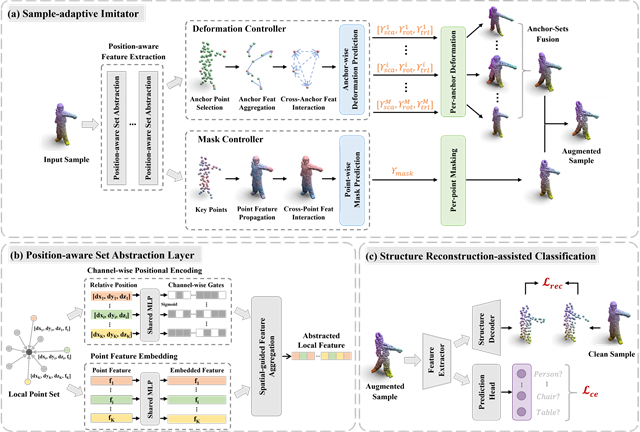

2.基于對抗學習的點云模式捕獲策略(NeurIPS 2024):該策略在訓練階段引入對抗性特征擦除機制,遮蔽模型已學習的目標模式,迫使從目標其他區(qū)域挖掘更具判別性的特征,進而強化對點云全局結(jié)構的感知能力(圖2)。

圖2. 基于對抗學習的點云模式捕獲策略。

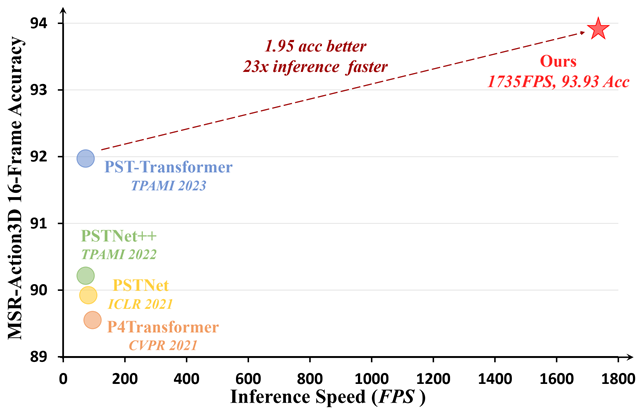

3.時序關聯(lián)高效建模框架(ICLR 2025):該框架通過關聯(lián)機制將輸入點云幀與捕捉到的時序動態(tài)信息相融合,提取深度運動線索并對整個序列的時序特征進行統(tǒng)一建模,有效降低計算冗余,顯著提升了處理效率(圖3)。

圖3. 不同模型精度與速度的性能對比。

通過以上系列研究,總體構建了面向復雜環(huán)境的點云目標魯棒識別一體化技術架構,成功突破了點云數(shù)據(jù)高效擴增、精細化特征表達以及運動特征高效挖掘等關鍵技術瓶頸。提出的系列方法顯著提升了點云識別模型在失真條件下的魯棒性與泛化性能,并大幅提高了識別效率。

該系列研究成果提升了復雜環(huán)境下點云感知技術的可靠性與實用性,為無人系統(tǒng)自主導航、空間目標感知等領域的實際應用奠定了重要的理論支撐與技術保障。

相關成果詳細信息:

[1] Li et al., Towards Robust Point Cloud Recognition with Sample-Adaptive Auto-Augmentation, IEEE TPAMI, 2025, vol. 47, no. 4, pp. 3003-3017.

論文鏈接:https://ieeexplore.ieee.org/document/10839114

[2] Wang et al., Target-Guided Adversarial Point Cloud Transformer Towards Recognition Against Real-world Corruptions, NeurIPS, 2024.

論文鏈接:https://openreview.net/pdf?id=FcUyz33OED

[3] Wang et al., PvNeXt: Rethinking Network Design and Temporal Motion for Point Cloud Video Recognition, ICLR, 2025.

論文鏈接:https://openreview.net/pdf?id=ZsU52Zkzjr

附作者信息:

王杰,北京理工大學光電學院博士研究生,主要研究方向為三維計算機視覺。在IEEE TPAMI、NeurIPS、ICCV、ICLR等頂級期刊或會議上發(fā)表論文6篇。

李佳男,北京理工大學光電學院,長聘副教授、博士生導師,主要研究方向為光電成像目標多維探測與感知技術研究。連續(xù)兩年入選全球前2%頂尖科學家(2023、2024年)。以第一或共同第一作者發(fā)表論文20篇,包括IEEE TPAMI論文5篇;以通訊作者發(fā)表論文60余篇。其中,3篇論文入選ESI高被引,2篇一作論文單篇引用超千次,谷歌學術總引用5600余次。主持國家自然科學基金、工信部高質(zhì)量發(fā)展專項(課題)等項目10項。入選中國科協(xié)、北京市科協(xié)青托。獲得地理信息科技進步二等獎(序2),中國圖象圖形學學會優(yōu)博,王大珩學生光學獎等。指導學生獲得反無人機跟蹤挑戰(zhàn)賽國際冠軍等競賽獎項10余項。研究成果應用于“中國天眼”、礦產(chǎn)開發(fā)遙感監(jiān)測等領域。

許廷發(fā),博士,教授/博導,國家一級重點學科“光學工程”學科責任教授,光電成像技術與系統(tǒng)教育部重點實驗室主任,北京理工大學重慶創(chuàng)新中心副主任。近年來帶領其科研團隊圍繞光電成像探測與識別、計算成像和人工智能等領域不斷深化研究。主持承擔國家自然科學基金委重大科研儀器研制項目等40余項。在國際、國內(nèi)等系列期刊發(fā)表學術論文200余篇,其中被SCI/EI收錄120余篇。以第一發(fā)明人申請國家發(fā)明專利87項,已授權和公示45項。獲省部級技進步二等獎等獎項3項。指導研究生獲得中國圖象圖形學學會優(yōu)秀博士學位論文,二人次獲得王大珩高校學生光學獎,三人次獲得全國光學與光學工程博士生學術聯(lián)賽全國百強,獲得中國高等教育博覽會“校企合作 雙百計劃”典型案例和重慶英才創(chuàng)新創(chuàng)業(yè)示范團隊等榮譽稱號。

分享到: